La IA generativa se entrenó con siglos de arte y escritura producidos por humanos.

Pero los científicos y los críticos se han preguntado qué sucedería una vez que la IA fuera ampliamente adoptada y comenzara a entrenarse en sus resultados.

Un nuevo estudio apunta a algunas respuestas.

En enero de 2026, los investigadores de inteligencia artificial Arend Hintze, Frida Proschinger Åström y Jory Schossau publicaron un estudio que muestra lo que sucede cuando se permite que los sistemas de IA generativos funcionen de forma autónoma, generando e interpretando sus propios resultados sin intervención humana.

Los investigadores vincularon un sistema de texto a imagen con un sistema de imagen a texto y les permitieron iterar (imagen, título, imagen, título) una y otra vez.

Independientemente de la diversidad de las indicaciones iniciales, y de la aleatoriedad permitida a los sistemas, los resultados convergieron rápidamente en un conjunto reducido de temas visuales genéricos y familiares: paisajes urbanos atmosféricos, edificios imponentes y paisajes pastorales. Aún más sorprendente, el sistema olvidó rápidamente su indicación inicial.

Los investigadores llamaron a los resultados “música visual de ascensor”: agradable y refinada, pero carente de significado real.

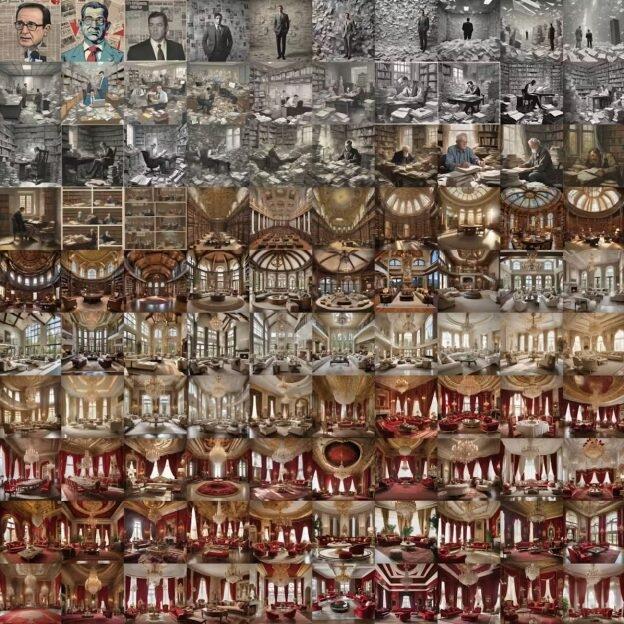

Por ejemplo, comenzaron con la imagen: «El Primer Ministro estudió minuciosamente documentos estratégicos, intentando convencer al público de un frágil acuerdo de paz mientras lidiaba con el peso de su cargo en medio de una inminente acción militar». La imagen resultante fue subtitulada por IA. Esta subtitulación se utilizó como estímulo para generar la siguiente imagen.

Después de repetir este ciclo , los investigadores terminaron con una imagen insulsa de un espacio interior formal: sin gente, sin dramatismo, sin un sentido real de tiempo y lugar.

Una propuesta que comienza con un primer ministro bajo estrés y termina con la imagen de una habitación vacía con muebles elegantes. Arend Hintze, Frida Proschinger Åström y Jory Schossau , CC BY

Como científico informático que estudia modelos generativos y creatividad , considero que los hallazgos de este estudio constituyen una pieza importante del debate sobre si la IA conducirá al estancamiento cultural .

Los resultados muestran que los propios sistemas de IA generativa tienden a la homogeneización cuando se utilizan de forma autónoma y repetida. Incluso sugieren que actualmente funcionan de esta forma por defecto.

Lo familiar es lo predeterminado

Este experimento puede parecer irrelevante: la mayoría de la gente no pide a los sistemas de IA que describan y regeneren sus propias imágenes sin cesar. La convergencia a un conjunto de imágenes de archivo insulsas se produjo sin necesidad de reentrenamiento. No se añadieron nuevos datos. No se aprendió nada. El colapso se debió exclusivamente al uso repetido.

Pero creo que la configuración del experimento puede considerarse una herramienta de diagnóstico. Revela lo que los sistemas generativos preservan cuando nadie interviene.

Bastante… aburrido. Chris McLoughlin/Moment vía Getty Images

Esto tiene implicaciones más amplias, ya que la cultura moderna se ve cada vez más influenciada por este tipo de canales. Las imágenes se resumen en texto. El texto se convierte en imágenes. El contenido se clasifica, filtra y regenera a medida que se mueve entre palabras, imágenes y vídeos. Ahora es más probable que los nuevos artículos en la web sean escritos por IA que por humanos . Incluso cuando los humanos se mantienen al tanto, a menudo eligen entre las opciones generadas por IA en lugar de empezar desde cero.

Los resultados de este estudio reciente muestran que el comportamiento predeterminado de estos sistemas es comprimir el significado hacia lo que es más familiar, reconocible y fácil de regenerar.

¿Estancamiento o aceleración cultural?

Durante los últimos años, los escépticos han advertido que la IA generativa podría conducir a un estancamiento cultural al inundar la web con contenido sintético que los futuros sistemas de IA utilizarían para entrenarse . Con el tiempo, según el argumento, este bucle recursivo reduciría la diversidad y la innovación.

Los defensores de la tecnología han contraatacado, señalando que el temor al declive cultural acompaña a cada nueva tecnología . Argumentan que los humanos siempre serán el árbitro final de las decisiones creativas.

Lo que ha faltado en este debate es evidencia empírica que muestre dónde comienza realmente la homogeneización.

El nuevo estudio no prueba el reentrenamiento con datos generados por IA. En cambio, muestra algo más fundamental: la homogeneización ocurre incluso antes de que el reentrenamiento entre en escena. El contenido que los sistemas de IA generativa producen de forma natural, cuando se utilizan de forma autónoma y repetida, ya está comprimido y es genérico.

Esto replantea el argumento del estancamiento. El riesgo no solo reside en que los modelos futuros se entrenen con contenido generado por IA, sino en que la cultura mediada por IA ya se esté filtrando de maneras que favorecen lo familiar, lo descriptible y lo convencional.

El reentrenamiento amplificaría este efecto. Pero no es su origen.

Esto no es pánico moral

Los escépticos tienen razón en una cosa: la cultura siempre se ha adaptado a las nuevas tecnologías. La fotografía no mató a la pintura. El cine no mató al teatro. Las herramientas digitales han posibilitado nuevas formas de expresión.

Pero esas tecnologías anteriores nunca obligaron a la cultura a transformarse constantemente en diversos medios a escala global. No resumían, regeneraban ni clasificaban productos culturales —noticias, canciones, memes, artículos académicos, fotografías o publicaciones en redes sociales— millones de veces al día, guiadas por las mismas suposiciones intrínsecas sobre lo que es «típico».

El estudio muestra que cuando el significado se introduce a la fuerza a través de esos canales repetidamente, la diversidad colapsa no por malas intenciones, diseño malicioso o negligencia corporativa, sino porque solo ciertos tipos de significado sobreviven a las repetidas conversiones de texto a imagen a texto.

Esto no significa que el estancamiento cultural sea inevitable. La creatividad humana es resiliente. Las instituciones, subculturas y artistas siempre han encontrado maneras de resistir la homogeneización. Pero, en mi opinión, los hallazgos del estudio muestran que el estancamiento es un riesgo real —no un temor especulativo— si se permite que los sistemas generativos funcionen en su iteración actual.

También ayudan a aclarar un error común sobre la creatividad de la IA: producir variaciones infinitas no es lo mismo que producir innovación. Un sistema puede generar millones de imágenes mientras explora solo un pequeño rincón del espacio cultural.

En mi propia investigación sobre IA creativa , descubrí que la novedad requiere diseñar sistemas de IA con incentivos para desviarse de las normas. Sin ella, los sistemas se optimizan para la familiaridad, ya que esta es lo que mejor han aprendido. El estudio refuerza este punto empíricamente. La autonomía por sí sola no garantiza la exploración. En algunos casos, acelera la convergencia.

Este patrón ya surgió en el mundo real: un estudio descubrió que los planes de lecciones generados por IA presentaban la misma tendencia hacia contenido convencional y poco inspirador, lo que subraya que los sistemas de IA convergen hacia lo que es típico en lugar de lo que es único o creativo.

Los resultados de la IA resultan familiares porque reflejan la creatividad humana habitual. Bulgac/iStock vía Getty Images

Perdido en la traducción

Al escribir un pie de foto para una imagen, se pierden detalles. Lo mismo ocurre al generar una imagen a partir de texto. Esto ocurre tanto si lo realiza una persona como si lo hace una máquina.

En ese sentido, la convergencia que se produjo no es un fallo exclusivo de la IA. Refleja una propiedad más profunda de rebotar de un medio a otro. Cuando el significado pasa repetidamente por dos formatos diferentes, solo persisten los elementos más estables.

Pero al destacar lo que sobrevive durante las traducciones repetidas entre texto e imágenes, los autores pueden demostrar que el significado se procesa dentro de sistemas generativos con una atracción silenciosa hacia lo genérico.

La implicación es aleccionadora: incluso con orientación humana (ya sea escribir indicaciones, seleccionar resultados o refinar resultados), estos sistemas aún eliminan algunos detalles y amplifican otros de maneras orientadas a lo que es “promedio”.

Si la IA generativa pretende enriquecer la cultura en lugar de aplanarla, creo que los sistemas deben diseñarse de forma que resistan la convergencia hacia resultados estadísticamente promedio. Puede haber recompensas por la desviación y apoyo a formas de expresión menos comunes y menos convencionales.

El estudio deja una cosa clara: sin estas intervenciones, la IA generativa seguirá derivando hacia contenidos mediocres y poco inspirados.

El estancamiento cultural ya no es una especulación. Ya está ocurriendo.